Détection de dérive et reprise automatique des LLM sur plateformes low‑code : architecturer alerting, rollback et audits immuables pour des pipelines résilients

Share

Introduction étendue

La montée en puissance des modèles de grande taille (LLM) a transformé les interactions digitales, l'automatisation des processus métier et la création de contenu. En 2025, l'usage des LLM s'est démocratisé grâce aux plateformes low‑code qui permettent de construire des applications conversationnelles et des assistants intelligents sans écrire beaucoup de code. Mais cette facilité d'adoption cache un risque opérationnel majeur : la dérive des modèles en production. Sans une stratégie robuste de détection de dérive, d'alerte, de reprise automatique et d'audit immuable, les entreprises s'exposent à des interruptions de service, des incidents de conformité et des pertes de confiance utilisateur.

Objectifs de cet article

- Expliquer les types de dérive spécifiques aux LLM

- Décrire une architecture détaillée et pragmatique adaptée aux plateformes low‑code

- Proposer des méthodes de détection et des règles d'alerting robustes

- Présenter des stratégies de reprise automatique et de rollback

- Détailler l'implémentation d'audits immuables et de traçabilité

- Fournir des playbooks, scripts pseudocode et checklists opérationnelles

Typologie détaillée de la dérive pour les LLM

- Population drift

- Changement dans la distribution des entrées utilisateurs: nouveaux segments clients, vocabulaire émergent, intentions différentes.

- Concept drift

- Modification de la relation attendue entre entrée et sortie: nouvelles règles métier, évolution réglementaire, ou changement de cible produit.

- Model drift

- Dérive due à mise à jour du modèle, finetuning, ou aux dépendances externes (APIs, prompt templates)

- Data pipeline drift

- Altération des ETL, perte de métadonnées, modifications de prétraitement qui impactent la qualité des prompts

- Operational drift

- Dégradations système: latence, throttling, changements de fournisseur cloud ou de quotas

Conséquences concrètes en production

- Augmentation des escalades humaines et des coûts support

- Décisions erronées entraînant risque réglementaire

- Perte de confiance client et churn

- Interruption de services critiques

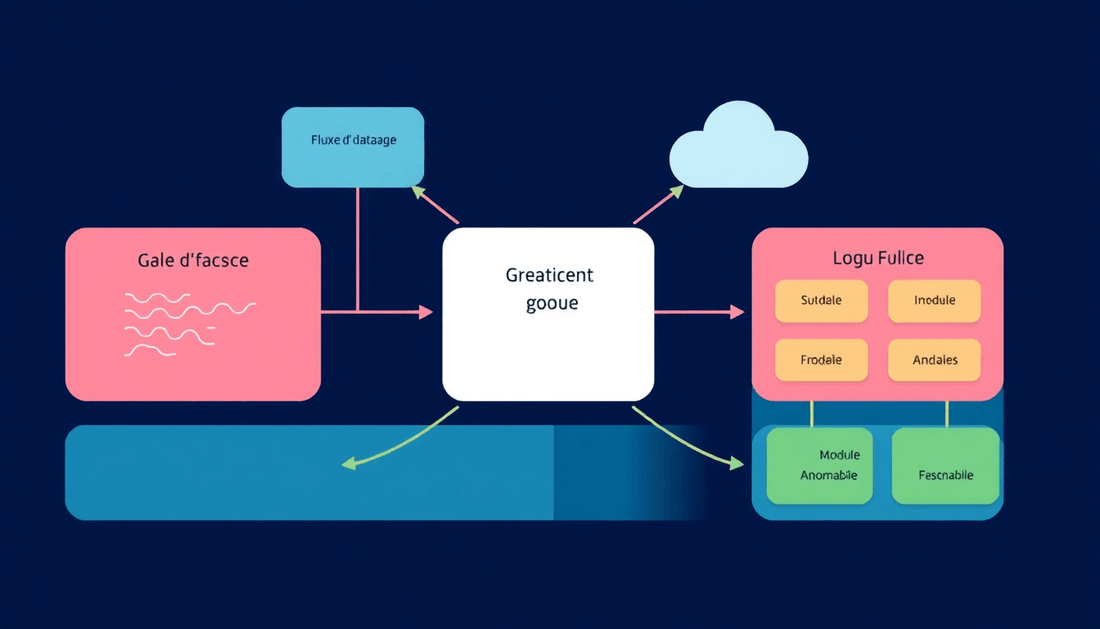

Architecture cible pour plateformes low‑code

Cette architecture met l'accent sur modularité, observabilité, et capacité d'action depuis l'interface low‑code.

- Collecte événementielle

- Connecteurs low‑code pour capter chaque appel: prompt, contexte, métadonnées utilisateur, version du modèle, latence et coût.

- Envoi sur un bus d'événements managé: Kafka, Pub/Sub, Kinesis ou équivalent low‑code.

- Stockage append‑only et indexé

- S3/Blob avec versioning et object lock pour immutabilité, ou base append‑only horodatée.

- Indexation des champs clés: id utilisateur, session, id de requête, version du modèle, hash du prompt/response.

- Pipelines de feature et embeddings

- Extracteurs de features runtime et batch: embeddings, comptages, métriques de sortie.

- Service de détection en streaming

- Fonctions serverless ou microservices consommant le bus pour calculer PSI, distances d'embeddings, perplexité approximée.

- Moteur d'alerting et orchestration

- Règles multi‑signal, paliers, et playbooks qui peuvent déclencher actions via API accessibles depuis l'interface low‑code.

- Registry modèle et catalogue de prompts

- Gestion des versions, métadonnées de performance et tags de conformité.

- Audit immuable et journal de décisions

- Stockage des artefacts d'incident, des décisions de rollback, et des preuves signées.

Méthodes de détection approfondies

Multipliez les approches pour augmenter la couverture et réduire les faux positifs.

1. Tests statistiques classiques

- PSI (Population Stability Index)

- Interprétation courante: PSI < 0.1 pas d'alerte, 0.1–0.25 alerte modérée, > 0.25 alerte critique.

- Pseudocode PSI:

calculate_psi(baseline, current): for each bucket i: expected = baseline[i] actual = current[i] psi += (actual - expected) * log(actual / expected) return psi

- KS test, JS divergence pour distributions continues ou discrètes

2. Méthodes basées sur embeddings

- Calculer les embeddings des prompts ou conversations et comparer:

- Distance cosine moyenne au centroide historique

- Distribution des distances: détecter queue heavy changes

- Pseudocode distance cosine:

cosine(a, b) = dot(a, b) / (norm(a) * norm(b)) mean_distance = mean([1 - cosine(e, centroid) for e in batch_embeddings])

3. Détection d'anomalies multivariée

- Isolation Forest, OneClass SVM, Autoencodeurs appliqués sur vecteurs de features composés (embeddings, longueur réponse, taux d'entités, perplexity estimée)

- Apprentissage supervisé: classifier d'anomalie si vous disposez de labels d'incident historiques

4. Tests sémantiques et qualité de sortie

- Factualité: vérifications externes via knowledge bases, checks de cohérence

- Toxicité et sécurité: modèles de modération en pipeline

- Contrôle d'attachement aux instructions: comparaison entre prompt intent et réponse

Règles d'alerting robustes

- Combiner signaux pour fiabiliser les alertes

- Exemple: alerte si PSI > 0.15 ET mean_cosine_distance > 0.2 ET augmentation de taux d'escalade > 25%

- Fenêtrage et persistance

- Ne pas déclencher sur flash spikes. Exiger persistance sur 15–60 minutes ou N requêtes consécutives anormales selon QPS.

- Paliers et actions associées

- Info: collecter snapshot et envoyer rapport automatisé

- Warning: augmenter taux de sampling, commencer capture d'artefacts immuables

- Critical: activer mitigation automatique (canary rollback, circuit breaker)

- Contextualisation d'alerte

- Inclure préconisations et playbook suggéré pour réduire le temps de décision humain

Stratégies de reprise et rollback détaillées

Blue/Green et Versioned Routing

- Maintenir version actuelle et version candidate en parallèle

- Basculement instantané du routage via configuration accessible par API depuis le low‑code

- Avantage: retour rapide, visibilité totale sur la version qui a causé l'incident

Canary progressive

- Déployer progressivement: 1% → 5% → 25% → 100%

- En cas d'anomalie durant rollout, rollback automatique au dernier palier sain

Circuit breaker et fallback

- Si taux d'erreurs ou latence dépasse threshold, ouvrir le circuit

- Fallbacks possibles

- Templates statiques

- Réponses guidées par règles métier

- Transfert vers agent humain

Rollback contrôlé

- Rollback automatique si métriques critiques ne reviennent pas dans MTTR cible

- Enregistrer chaque rollback comme événement d'audit immuable avec justification et hash des artefacts

Audit immuable et traçabilité complète

L'audit immuable est la colonne vertébrale de la confiance et de la conformité.

- Stockage append‑only

- Utiliser object lock, snapshots horodatés et contrôle d'accès immuable

- Hashing et Merkle trees

- Calculer un hash des prompts, responses et métadonnées, puis construire Merkle trees pour prouver intégrité

- Signatures et journaux d'actions

- Signer les actions critiques (rollback, deploy) avec clé organisationnelle

- Indices de recherche et conformité

- Index par utilisateur, modèle, version, timeframe et raison de l'alerte

- Retention et anonymisation

- Appliquer masquage ou tokenisation des données personnelles avant archivage irréversible si nécessaire pour RGPD

Exemples pratiques et pseudocode

Exemple simple de détection de dérive par embeddings et action automatique

1. Pour chaque nouvelle requete:

a. Calculer embedding e

b. Calculer distance d = 1 - cosine(e, centroid_reference)

c. Si d > seuil_distance pour M requetes consécutives ET PSI > seuil_psi:

- Publier alerte critical au bus d'orchestration

- Activer circuit_breaker via API

- Capturer snapshot et archiver immuable

- Basculement vers fallback ou version précédente

Dashboards recommandés

- Vue tempo des métriques: PSI, mean cosine distance, perplexity estimée, taux d'hallucination

- Performance modèle par version: latence p50/p95/p99, taux d'erreur, coût tokens

- Indicateurs métier: taux de conversion, CSAT, taux d'escalade

- Journal d'audit: derniers rollbacks, raisons, artefacts associés

Intégration concrète avec plateformes low‑code

- Connecteurs natifs

- Configurer le low‑code pour pousser events vers un endpoint centralisé ou un bus managé

- Actions exposées via API

- Exposer endpoints pour changer routing, activer fallback, et lancer snapshots immuables. Ces endpoints doivent être consommables par le mécanisme d'automatisation low‑code.

- Fonctions serverless pilotées par low‑code

- Composer tâches serverless depuis l'interface visuelle pour calculs heavy sans coder l'infra

- UI pour opérateurs

- Boutons de rollback, historique d'audit, et visualisation des playbooks accessibles sans dev

Gouvernance, sécurité et conformité

- Contrôles d'accès granulaires pour actions critiques (rollback, modif de routing)

- Chiffrement des artefacts en transit et au repos

- Masquage et suppression des données sensibles avant archivage immutable

- Traçabilité cryptographique pour prouver non altération

- Processus de revue réglementaire pour preuves d'audit en cas d'incident

Coût, scalabilité et optimisation

- Equilibrer fréquence de capture des artefacts et coûts de stockage: sampling adaptatif

- Découper pipelines de détection en realtime pour les signaux critiques et batch pour analyses lourdes

- Compression et deduplication des prompts et responses avant archivage

- Utiliser embeddings légers pour haut débit et embeddings plus riches en analyse batch

Playbooks détaillés et runbook

- Playbook incident critique

- 1. Détection: alerte critical déclenchée

- 2. Mitigation immédiate: activer circuit breaker, basculer trafic via blue/green

- 3. Collecte: snapshot complet immuable, logs, métriques et hashes

- 4. Analyse: run automated checks (PSI, embeddings, toxicité) et escalade vers équipe ML

- 5. Décision: rollback automatisé si MTTR cible atteint ou intervention manuelle si nécessaire

- 6. Post‑mortem et amélioration: documenter RCA, mettre à jour thresholds et tests.

- Runbook de test périodique

- Tests de canary hebdomadaires, exercices de rollback trimestriels

- Vérifications de l'intégrité des archives immuables

Études de cas synthétiques

- Cas A: dérive saisonnière

- Symptômes: hausse progressive des distances d'embeddings liés à nouveaux termes promotionnels

- Réponse: ajustement des prompts, mise à jour d'un fine tuning léger, déploiement canary et monitoring rapproché

- Cas B: régression après finetuning

- Symptômes: augmentation des hallucinations et baisse CSAT

- Réponse: rollback vers la version antérieure via blue/green, conservation de snapshots, et analyse des gradients du fine tuning

KPIs détaillés et reporting

- MTTD et MTTR par service et par version

- Taux d'incidents récurrents liés à dérive

- KPI métier impactés: CSAT, NPS, conversion

- Coût des appels LLM et coût du stockage d'archives immuables

- Pourcentage de requêtes couvertes par audits immuables

Pièges courants et leçons apprises

- Trop se fier à une seule métrique

- Sous‑estimer la latence d'analyse: certains tests nécessitent batch et cannot be instant

- Absence de playbooks testés rend la reprise lente

- Conserver des données sensibles sans anonymisation avant archivage immuable

- Ne pas prévoir de rollback manuel en cas de panne de l'automatisation

Checklist opérationnelle détaillée

- 1. Instrumentation:

- Connecteurs low‑code pour chaque point d'entrée

- Collecte de prompt, context, response, metrics

- 2. Observabilité:

- Streaming vers bus, stockage append‑only, indexation

- 3. Détection:

- Implémenter PSI, tests embeddings, detection multivariée

- 4. Alerting:

- Règles multi‑signal et paliers, notifications on‑call

- 5. Reprise:

- Actions API: canary, blue/green, circuit breaker, fallback

- 6. Audit:

- Hashing, signatures, retention et anonymisation

- 7. Tests et exercices:

- Tests automatisés, runbooks, simulations trimestrielles

Ressources et outils recommandés

- Outils de streaming: Kafka, Pub/Sub, Kinesis

- Stockage immuable: S3 avec object lock, solutions compatibles avec verrouillage d'objets

- Librairies de détection: scikit‑learn, river pour streaming, isolation forest

- Outils d'observabilité: Prometheus, Grafana, ou solutions SaaS avec intégration low‑code

- Gestion des modèles: registries légères offrant versioning et métadonnées

Feuille de route d'implémentation en 90 jours

- Semaine 1–2: inventaire des points d'intégration, définition des KPIs et SLO

- Semaine 3–6: instrumentation de base, streaming des événements et stockage append‑only

- Semaine 7–10: déploiement des pipelines de détection en streaming et dashboards

- Semaine 11–12: implémentation des actions API pour rollback et circuit breaker

- Trimestre suivant: exercices de reprise, audits immuables et automatisation des playbooks

Conclusion approfondie

La résilience des pipelines LLM sur plateformes low‑code repose sur une approche systémique: capture exhaustive des artefacts, détection multi‑signal, alerting structuré, capacités de reprise automatisée et preuve immuable pour audit. En combinant ces composants et en appliquant des playbooks testés, les organisations peuvent réduire significativement le risque opérationnel, maintenir la conformité et conserver la confiance des utilisateurs. Commencez petit avec des canaries et des alerts simples, puis élargissez vers des audits immuables et une automatisation complète.

Appel à l'action

Pour aller plus loin: établissez votre premier plan d'implémentation 90 jours, identifiez les trois métriques critiques à monitorer dès aujourd'hui, et lancez un premier exercice de rollback sur une sandbox low‑code pour valider vos playbooks.