Intégration des données pour l'IA, le low-code et l'automatisation en gestion de projet : bâtir des workflows fiables et scalables

Share

Introduction

À l'ère de la transformation numérique accélérée, les équipes de gestion de projet doivent concilier rapidité d'exécution, qualité des décisions et maîtrise des risques. L'intégration des données devient la colonne vertébrale de cette performance : elle alimente les modèles d'IA, oriente les automatisations low-code et garantit des workflows répétables et scalables. Cet article approfondi présente une vision pratique et technique pour concevoir, déployer et exploiter des pipelines d'intégration adaptés aux besoins des projets modernes.

Pourquoi ce sujet est essentiel aujourd'hui

- Explosion des sources de données : outils de ticketing, CRM, ERP, outils de collaboration, logs, capteurs IoT, etc.

- Montée en puissance de l'IA : besoin de datasets propres et versionnés pour entraîner et déployer des modèles fiables.

- Adoption rapide du low-code : permet aux équipes métiers d'automatiser des tâches, mais nécessite des données cohérentes et sécurisées.

- Besoin d'agilité et de scalabilité : évoluer rapidement sans casser les workflows existants.

Vue d'ensemble des objectifs à atteindre

- Centraliser et standardiser les données critiques de projet.

- Fournir des pipelines observables, testés et résilients.

- Permettre des intégrations temps réel et batch selon les besoins.

- Garantir conformité et sécurité tout en préservant l'agilité métier.

- Assurer la gouvernance, la traçabilité et le versioning des datasets et modèles.

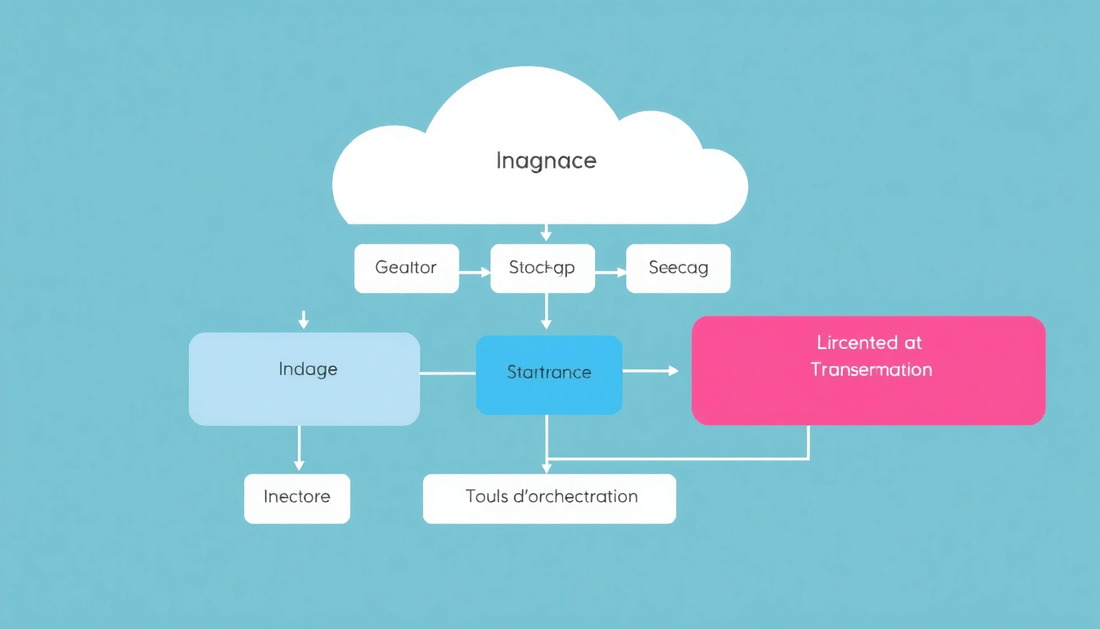

Architecture cible recommandée

Voici une architecture de référence, modulable selon la taille et les priorités :

- Couche d'ingestion : connecteurs batch et CDC pour capter les changements (Airbyte, Fivetran, Debezium, connecteurs low-code).

- Zone de stockage brut : lac de données pour conserver les événements et snapshots originaux (S3, ADLS).

- Entrepôt / zone de consommation : tables transformées et optimisées pour analytics et consommation application (Snowflake, BigQuery, Synapse).

- Couche de transformation : ELT avec dbt ou transformations Spark pour quality checks et logique métier.

- Orchestration : orchestrateur pour gérer dépendances, retries et notifications (Airflow, Prefect, Dagster).

- MLOps et feature store : gérer le cycle de vie des modèles et des features (MLflow, Feast).

- Couche d'intégration métier : APIs, webhooks et plateformes low-code pour automatisations et interventions humaines (Power Automate, n8n, Make).

- Observabilité et sécurité : logging centralisé, métriques, tracing, IAM et chiffrement.

Design patterns clés pour fiabilité et scalabilité

- Idempotence : chaque opération doit pouvoir être rejouée sans effet secondaire indésirable.

- Event-sourcing quand approprié : conserver événements sources pour reconstitution de l'état.

- CDC pour synchronisation efficace : capture des changements pour minimiser latence et coût.

- Schema evolution controlée : compatibilité ascendante et registre de schémas.

- Ségrégation des responsabilités : séparation entre pipelines de données, orchestration métier et consommation IA.

Qualité des données et tests automatisés

La qualité des données est souvent l'élément limitant pour des projets IA et d'automatisation. Voici un plan de tests à automatiser :

- Tests unitaires de transformations : vérifier que chaque transformation renvoie les résultats attendus.

- Tests d'intégration : valider que les connecteurs ingèrent correctement les sources.

- Tests de qualité : completude, unicité, formats, contraintes métier (ex. dates, identifiants).

- Tests de performance : latence d'ingestion, temps de traitement pour batchs critiques.

- Tests de non-régression sur les features IA : s'assurer que les transformations n'introduisent pas de dérive.

Gouvernance, sécurité et conformité

Construire des workflows fiables implique aussi de maîtriser la gouvernance et la sécurité :

- RGPD et données personnelles : anonymisation ou pseudonymisation, consentement et gestion des droits d'accès.

- Contrôle d'accès granulaire : RBAC, attribut-based access control (ABAC) pour limiter la portée des actions.

- Chiffrement : TLS pour la transmission, chiffrement au repos par clé gérée (KMS).

- Audits et traçabilité : conserver l'historique des modifications, qui a lancé quel pipeline, et versions deployées.

- Data contracts : contrats explicites entre producteurs et consommateurs de données (schémas, SLAs, qualité attendue).

Intégration low-code et automatisation : bonnes pratiques

Le low-code accélère mais peut aussi devenir source de dettes techniques s'il est mal encadré :

- Cataloguer les automatisations low-code et les soumettre aux mêmes politiques de sécurité et versioning.

- Limiter les automatisations critiques : utiliser low-code pour orchestration non critique et confier les traitements lourds à des pipelines contrôlés.

- Exposer des APIs stables pour le low-code afin d'éviter de multiplier les connecteurs adhoc.

- Imposer des revues et approbations pour les workflows qui modifient les données sources.

Exemple détaillé : pipeline end-to-end pour priorisation des tickets via IA

Objectif : prioriser automatiquement les tickets de support en fonction d'urgence, impact client et coûts projet, et déclencher des workflows d'escalade et d'information.

- Sources : Jira (tickets), CRM (données client), ERP (coûts/contrats), logs applicatifs.

- Ingestion : CDC pour Jira et ERP, batch pour CRM chaque nuit via Airbyte.

- Stockage : zone raw dans S3, tables consolidées dans Snowflake.

- Transformation : normalisation des champs, enrichissement client, calcul de features (temps moyen de résolution, criticité selon SLA).

- Modélisation : modèle de classification (score de priorité) entraîné via MLOps, features stockées dans Feast.

- Déploiement : modèle servi via endpoint REST, score calculé en temps réel lors de la création du ticket.

- Automatisation low-code : workflow dans n8n déclenche notifications, création de sous-tâches et escalades selon le score et le coût projet.

- Monitoring : suivi des performances du modèle, taux d'escalade, latence de bout en bout.

Checklist de mise en œuvre (actionnable)

- Inventaire des sources et des formats (fields, fréquence, propriétaire).

- Définition des cas d'usage prioritaires et des KPIs associés.

- Choix d'un prototype : sélection d'un outil d'ingestion léger et d'un orchestrateur.

- Conception d'un data contract et d'un registre de schémas.

- Mise en place des tests automatisés et pipelines CI/CD pour les transformations.

- Implémentation des contrôles de sécurité et des politiques d'accès.

- Déploiement pilote, collecte de feedback métier, itération.

- Industrialisation et documentation (catalogue de datasets, runbooks).

Plan de déploiement en phases

Pour limiter les risques et maximiser l'adoption :

- Phase 0 – Préparation (2–4 semaines) : audit, priorisation, choix technologique.

- Phase 1 – Prototype (4–8 semaines) : POC sur 1 cas d'usage, validation SLA et qualité.

- Phase 2 – MVP (2–3 mois) : industrialisation du pipeline, orchestration, alerting basique.

- Phase 3 – Production (3–6 mois) : gouvernance, MLOps, automatisations low-code, échelle.

- Phase 4 – Optimisation continue (en continu) : coûts, performance, extension à d'autres domaines.

Métriques et KPIs à monitorer en continu

- Disponibilité des pipelines et taux d'échec quotidien.

- Latence bout en bout pour les cas temps réel.

- Freshness des datasets critiques.

- Qualité des données : pourcentage de champs invalides, doublons.

- Performance IA : précision, rappel, F1, dérive conceptuelle.

- Adoption métier des workflows low-code (nombre de run, taux d'automatisation).

- Coût total de possession : coûts d'ingestion, stockage, transformation et compute.

Risques communs et comment les éviter

- Silos low-code non gouvernés : imposer catalogue et politiques d'accès.

- Dérive des modèles IA : monitorer les features et mettre en place retraining automatique.

- Perte de traçabilité : loguer chaque exécution avec métadonnées et identifiants.

- Problèmes de performance en montée en charge : effectuer des tests de montée et optimiser les partitions, indexes et cluster sizing.

- Coûts imprévus cloud : mettre en place des budgets, alerts et optimisations de coûts (compaction, format colonnaire).

Comparatif rapide de technologies selon les besoins

- Besoin d'ingestion simple et rapidité : Airbyte, Fivetran.

- Besoin streaming et latence faible : Kafka + Debezium, Pulsar.

- Analytics SQL-friendly et partage facile : Snowflake, BigQuery.

- Transformations orientées versioning et tests : dbt.

- Orchestration fiable et observable : Airflow pour batchs complexes, Prefect/Dagster pour expérience dev moderne.

- Automatisation métier accessible : Power Automate en écosystème Microsoft, n8n/Make pour flexibilité et faible coût.

Exemples concrets de scripts et requêtes utiles

Exemple de requête pour vérifier la fraîcheur d'une table dans l'entrepôt :

SELECT max(updated_at) as last_update, count(*) as rows FROM projet_tickets_consolide;

Exemple d'alerte basique en pseudo-code pour latence :

if (now() - table.last_update) > threshold:

send_alert('Données stale: ' + dataset_name)

Organisation, rôles et compétences nécessaires

Une intégration de données efficace nécessite une équipe pluridisciplinaire :

- Data Engineer : pipelines, ingestion, transformations et orchestration.

- Data Product Owner : définit les contrats de données et priorise les cas d'usage.

- ML Engineer / MLOps : gestion des modèles, feature stores, retraining.

- DevOps / Cloud Engineer : sécurité, IAM, monitoring et optimisation coûts.

- Architecte données : gouvernance globale, choix technologiques, patterns.

- PMO / Chef de projet : coordination entre IT et métier, adoption et changement.

Change management et adoption métier

L'aspect humain est souvent sous-estimé. Pour une adoption réussie :

- Impliquer les utilisateurs dès le design du cas pilote.

- Former et documenter : guides, FAQ, sessions hands-on.

- Mesurer l'impact visible : temps gagné, erreurs évitées, valeur financière.

- Créer des champions métiers pour encourager l'utilisation et remonter les retours.

Exemples de cas d'usage additionnels

- Prévision de charge projet et allocation de ressources via modèles de séries temporelles.

- Détection proactive des risques (retards, dépassements de budget) par corrélation multi-source.

- Automatisation de facturation et rapprochement financier entre ERP et feuille de temps.

- Analyse de sentiments sur retours clients pour prioriser features et corrections.

FAQ (questions longue traîne pour SEO)

- Qu'est-ce qu'un data contract en contexte projet ? Un accord formel entre producteur et consommateur définissant schéma, SLAs de fraîcheur, qualité et contact en cas d'anomalie.

- Quand choisir CDC plutôt que batch ? CDC pour latence faible et synchronisation continue ; batch pour traitements moins critiques et optimisation coûts.

- Comment monitorer la dérive d'un modèle IA ? Suivre la distribution des features, le drift des labels, et mesurer l'écart des metrics production vs validation.

- Le low-code remplace-t-il les data engineers ? Non : il accélère l'automatisation métier mais les data engineers conçoivent et maintiennent l'infrastructure, la qualité et la sécurité.

Ressources et lectures recommandées

- Articles et guides sur ELT moderne, dbt et architectures data lakehouse.

- Documentation des solutions mentionnées : Airbyte, Debezium, Snowflake, dbt, Prefect.

- Ouvrages sur Data Mesh et gouvernance des données pour les grandes organisations.

Conclusion et appel à l'action

L'intégration des données pour l'IA, le low-code et l'automatisation est un levier stratégique pour accélérer la valeur en gestion de projet. En combinant une architecture bien pensée, des pratiques de qualité, une gouvernance forte et une approche itérative, vous pouvez bâtir des workflows robustes et scalables. Commencez par un petit pilote à fort impact, formalisez vos data contracts et industrialisez progressivement.

Souhaitez-vous une checklist personnalisée, un plan de migration technique ou un atelier de 2 heures pour identifier votre premier cas pilote ? Je peux créer un plan détaillé adapté à votre contexte.